L’évolution rapide des outils d’intelligence artificielle transforme la manière dont les images sont créées, partagées et perçues. Au cœur de cette révolution, OpenAI, déjà reconnu pour ses solutions comme DALL-E ou ChatGPT, franchit une nouvelle étape en annonçant l’intégration de filigranes sur les images générées par IA. Cette décision s’inscrit dans une démarche de transparence, alors que la question de la véracité des contenus numériques devient centrale.

Dans un contexte où le marché regorge de contenus synthétiques, il devient difficile de distinguer une création artificielle d’une photographie authentique. En ajoutant un marquage systématique aux images produites par IA, OpenAI démontre sa volonté de responsabiliser les usages technologiques et d’anticiper les attentes des utilisateurs, des médias et des régulateurs face à l’expansion fulgurante de l’IA générative.

Pourquoi OpenAI privilégie-t-il les filigranes ?

La question de l’authenticité visuelle préoccupe de nombreux acteurs du numérique. Chaque jour, des milliers d’images générées par IA circulent sur les réseaux sociaux, brouillant la frontière entre réalité et fiction. Avec cette initiative, OpenAI cherche à apporter une réponse concrète à ce défi tout en renforçant la transparence autour de ses technologies.

L’objectif affiché est double : limiter l’usage détourné des images synthétiques et instaurer un climat de confiance auprès du grand public. Le filigrane, qu’il soit visible ou dissimulé via une marque invisible, sert de preuve formelle du caractère généré du visuel. Pour OpenAI, il s’agit aussi de mieux contrôler les usages non conformes susceptibles de porter atteinte à la réputation du modèle et de menacer la crédibilité des œuvres originales.

Quelles modalités techniques pour le marquage des images ?

L’aspect technique de cette mesure repose principalement sur l’intégration de signatures numériques ou de filigranes graphiques à chaque image produite. Plusieurs options sont envisagées, du logo superposé au filigrane invisible incrusté dans les métadonnées, une méthode déjà éprouvée lors d’événements sensibles par des agences telles que l’AFP.

Le principal enjeu réside dans l’équilibre entre visibilité et discrétion. Un filigrane trop visible pourrait nuire à l’expérience utilisateur et à la qualité artistique, tandis qu’un marquage trop subtil risquerait de passer inaperçu. L’idéal se situe donc entre protection, traçabilité et respect de l’esthétique finale. Ce choix traduit la volonté d’OpenAI d’imposer une norme sans entraver la créativité ni stigmatiser l’utilisation de ses outils.

- 🔒 Sécurité des œuvres contre la falsification

- 🖼️ Respect de la qualité visuelle

- 🔍 Traçabilité facilitée grâce aux métadonnées

- ⚙️ Compatibilité avec différents formats de publication

Impact attendu sur l’écosystème de la création numérique

Quelle évolution pour les usages professionnels et médiatiques ?

L’arrivée des filigranes va entraîner une adaptation rapide au sein des rédactions et agences de communication. La capacité à identifier clairement une image générée par IA deviendra essentielle, notamment pour la couverture d’événements ou la diffusion d’informations sensibles. Plusieurs organismes internationaux expérimentent déjà des dispositifs similaires pour contrer la prolifération d’images truquées.

En transférant une partie de la vérification vers l’outil lui-même, journalistes et éditeurs gagnent en efficacité. Une image explicitement estampillée “générée par IA” peut être rapidement identifiée lors du traitement de l’information, réduisant ainsi le risque de diffusion involontaire de contenus manipulés.

Quels changements pour les utilisateurs individuels ?

Côté grand public, le marquage automatique imposera de nouvelles habitudes. Les créateurs amateurs ou artistes utilisant DALL-E devront intégrer cette contrainte dans leur processus de création. Certains verront cela comme une limitation supplémentaire, tandis que d’autres apprécieront l’effort de clarté dans les circuits de partage d’images.

L’accès facilité à l’information sur l’origine d’une image encourage une analyse critique chez les internautes. Cette approche pédagogique rejoint une tendance visant à sensibiliser les utilisateurs aux risques de désinformation visuelle. L’enjeu ne se limite pas à la technique, il touche aussi à l’éthique et à la responsabilité collective face à la consommation de contenus numériques.

Le positionnement d’OpenAI face à la concurrence

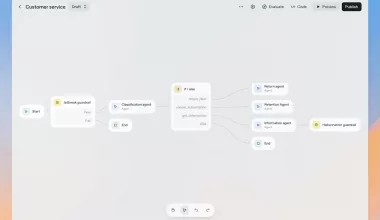

OpenAI n’est pas le seul à chercher des réponses à l’incertitude provoquée par la multiplication des images artificielles. Des agences de presse internationales comme l’AFP, mais aussi des sociétés spécialisées en cybersécurité, recourent déjà à diverses formes de filigranage pour garantir l’authenticité de leurs productions.

Cependant, la généralisation de ces pratiques par OpenAI, dont les services touchent un large public, constitue un tournant. Alors que certaines plateformes concurrentes préfèrent adopter des chartes d’usage, OpenAI opte pour un mécanisme contraignant et systématique. Cette stratégie pourrait inspirer d’autres acteurs à établir des standards communs à l’industrie.

| 🏢 Plateforme | 🔗 Méthode de filigranage | 🌍 Cible principale |

|---|---|---|

| OpenAI (DALL-E) | Visible & invisible | Grand public / entreprises |

| AFP | Watermark invisible | Médias / agences presse |

| Bing Image Creator | Aucune systématique | Utilisateurs variés |

Quelles perspectives pour la régulation des contenus IA ?

Le débat autour du marquage des images générées soulève des questions réglementaires. La Commission européenne et d’autres autorités nationales élaborent actuellement des textes visant à encadrer la transparence et la traçabilité des contenus produits par l’IA. OpenAI anticipe donc de potentielles obligations futures en adoptant une posture proactive, tout en surveillant l’impact réel de ces mesures sur les pratiques de ses millions d’utilisateurs.

Les prochaines étapes dépendront des retours recueillis lors du déploiement, mais aussi des réactions des concurrents, partenaires et de la communauté créative. Le standard fixé aujourd’hui par OpenAI pourrait durablement influencer la gestion de la fiabilité et de la traçabilité des images appelées à circuler demain sur toutes les plateformes numériques.